Apple випустила мовні моделі OpenELM для роботи без Інтернету

Компанія Apple представила нову серію мовних моделей OpenELM, розроблених для локальної роботи на пристроях без необхідності підключення до хмарних сервісів. Серія включає вісім моделей різного розміру та типу, які варіюються від 270 мільйонів до 3 мільярдів параметрів.

Ці моделі були навчені на величезних публічних наборах даних, включаючи 1,8 трильйона токенів з таких ресурсів, як Reddit, Wikipedia та arXiv.org. Завдяки високому ступеню оптимізації, моделі OpenELM здатні функціонувати на звичайних ноутбуках і навіть деяких смартфонах, що було демонстровано на таких пристроях, як ПК з Intel i9 і RTX 4090 та MacBook Pro з чіпом M2 Max.

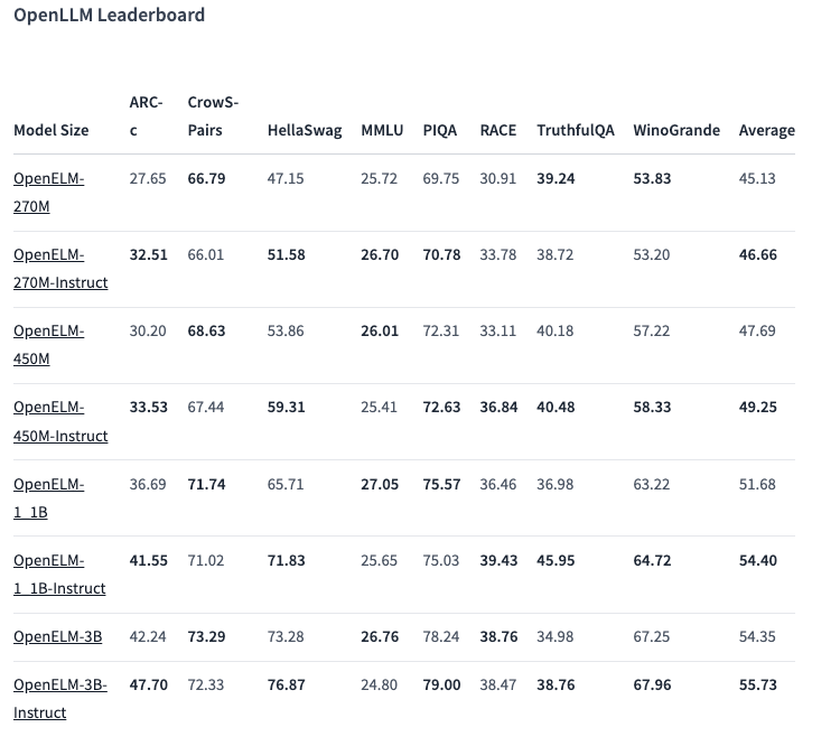

Один з виділених варіантів, модель на 450 мільйонів параметрів, з інструкціями показала відмінні результати. Модель OpenELM-1.1B з 1,1 млрд параметрів виявилася ефективнішою за аналогічну модель GPT, OLMo, на 2,36%, при цьому використовуючи вдвічі менше даних для навчання.

У бенчмарку ARC-C, призначеному для тестування знань і логічного міркування, попередньо навчений варіант OpenELM-3B показав точність у 42,24%. На інших тестах, таких як MMLU та HellaSwag, модель набрала 26,76% та 73,28% відповідно.

Apple також опублікувала вихідний код OpenELM на платформі Hugging Face під відкритою ліцензією, надавши доступ до навчених моделей, бенчмарків та інструкцій для роботи з цими моделями. Втім, компанія попереджає, що моделі можуть видавати некоректні, шкідливі або неприйнятні відповіді через відсутність гарантій безпеки.